La saggezza convenzionale dice: "Se non vuoi che i tuoi dati vengano utilizzati, ritirati da tutto".

Noi diciamo: "Se i tuoi dati vengono raccolti comunque, è più razionale influenzare come vengono utilizzati".

Non è: "Le aziende dovrebbero avere i miei dati?" (Li hanno già).

La vera domanda è: "I miei dati dovrebbero contribuire a costruire un'IA migliore per tutti?"

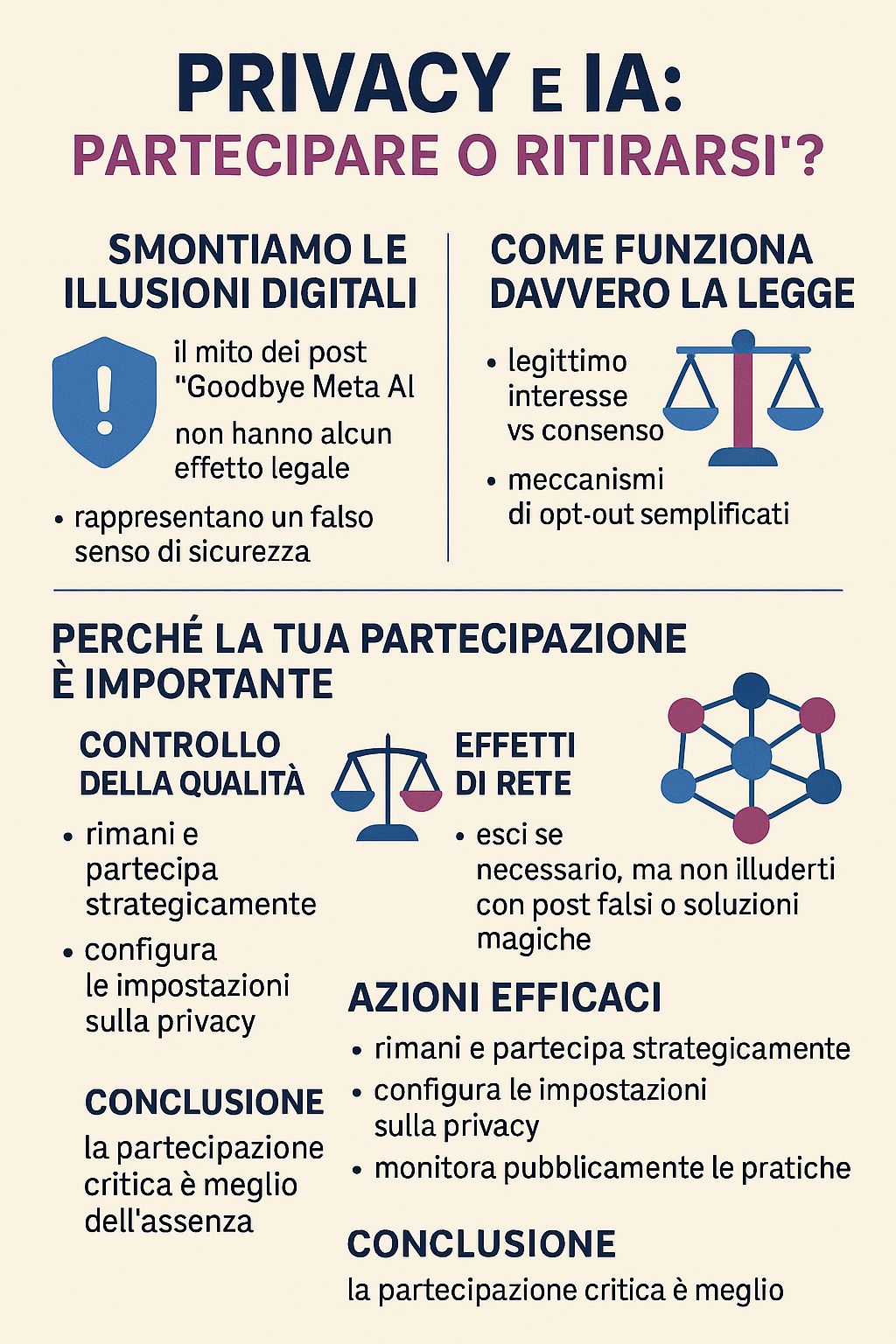

Prima di costruire un'argomentazione seria, è fondamentale smontare una pericolosa illusione che circola sui social: i post virali "Goodbye Meta AI" che promettono di proteggere i tuoi dati semplicemente condividendo un messaggio.

La verità scomoda: questi post sono completamente fasulli e possono renderti più vulnerabile.

Come spiegato da Meta stessa, "condividere il messaggio 'Goodbye Meta AI' non costituisce una forma valida di opposizione". Questi post:

Il successo virale di questi post rivela un problema più profondo: preferiamo soluzioni semplici e illusorie a decisioni complesse e informate. Condividere un post ci fa sentire attivi senza richiedere la fatica di capire davvero come funzionano i nostri diritti digitali.

Ma la privacy non si difende con i meme. Si difende con la conoscenza e l'azione consapevole.

Dal 31 maggio 2025, Meta ha implementato un nuovo regime per l'addestramento dell'IA utilizzando come base giuridica il "legittimo interesse" anziché il consenso. Questa non è una scappatoia, ma uno strumento legale previsto dal GDPR.

Il legittimo interesse permette alle aziende di trattare dati senza consenso esplicito se possono dimostrare che il loro interesse non prevalga sui diritti dell'utente. Questo crea una zona grigia dove le aziende "tarano la legge su misura" attraverso valutazioni interne.

L'utilizzo di dati non anonimizzati comporta "rischi elevati di inversione del modello, memorization leaks e extraction vulnerabilities". Il potere computazionale necessario significa che solo attori ad altissima capacità possono sfruttare efficacemente questi dati, creando asimmetrie sistemiche tra cittadini e grandi corporazioni.

Ora che abbiamo chiarito la realtà legale e tecnica, costruiamo l'argomento per la partecipazione strategica.

Quando le persone consapevoli rinunciano, l'IA si allena su chi rimane. Vuoi che i sistemi di IA si basino principalmente sui dati di persone che:

I pregiudizi nell'IA si verificano quando i dati di addestramento non sono rappresentativi. La tua partecipazione contribuisce a garantire:

I sistemi di IA migliorano con la scala e la diversità:

Se usi funzionalità basate sull'IA (ricerca, traduzione, consigli, strumenti di accessibilità), la tua partecipazione contribuisce a migliorarle per tutti, compresi i futuri utenti che ne hanno più bisogno.

La tua privacy non cambia significativamente tra opt-in e opt-out per l'IA. Gli stessi dati alimentano già:

La differenza è se questi dati contribuiscono anche a migliorare l'IA per tutti o servono solo gli interessi commerciali immediati della piattaforma.

Questo è esattamente il motivo per cui persone responsabili come te dovrebbero partecipare. Ritirarsi non ferma lo sviluppo dell'IA, ma semplicemente rimuove la tua voce da esso.

I sistemi di IA verranno sviluppati comunque. La domanda è: con o senza il contributo di persone che riflettono criticamente su questi temi?

Comprensibile. Ma considera questo: preferiresti che i sistemi di IA fossero costruiti con o senza il contributo di persone che condividono il tuo scetticismo verso le grandi corporazioni?

La tua sfiducia è proprio il motivo per cui la tua partecipazione critica è preziosa.

L'intelligenza artificiale sta diventando realtà, che tu partecipi o meno.

La tua scelta non è se l'IA verrà costruita, ma se l'IA che verrà costruita rifletterà i valori e le prospettive delle persone che riflettono attentamente su questi temi.

Fare opt-out è come non votare. Non ferma le elezioni, significa solo che il risultato non terrà conto del tuo contributo.

In un mondo dove solo attori ad altissima capacità computazionale possono interpretare e sfruttare efficacemente questi dati, la tua voce critica nell'addestramento può avere più impatto della tua assenza.

Rimani e partecipa strategicamente se:

E nel frattempo:

Ma non illuderti con:

La tua rinuncia individuale ha un impatto minimo sulla tua privacy, ma restare ha un impatto reale su tutti.

In un mondo in cui i sistemi di IA determineranno il flusso di informazioni, le decisioni e le interazioni tra le persone e la tecnologia, la questione non è se questi sistemi debbano esistere, ma se debbano includere il punto di vista di persone riflessive e critiche come te.

A volte, l'azione più radicale non è rinunciare. Spesso, il modo più radicale è rimanere e assicurarsi che la propria voce venga ascoltata.

Anonimo

Non si tratta di fidarsi ciecamente delle aziende o di ignorare le preoccupazioni relative alla privacy. Si tratta di riconoscere che la privacy non si difende con i meme, ma con la partecipazione strategica e consapevole.

In un ecosistema dove le asimmetrie di potere sono enormi, la tua voce critica nell'addestramento dell'IA può avere più impatto della tua assenza protestataria.

Qualunque sia la tua scelta, scegli con consapevolezza, non con illusioni digitali.

Un paragrafo di simpatia anche per gli "eremiti della privacy" - quelle anime pure che credono di poter sfuggire completamente al tracciamento digitale vivendo offline come monaci tibetani del 2025.

Spoiler: anche se vai a vivere in una baita sperduta nelle Dolomiti, i tuoi dati sono già ovunque. Il tuo medico di base usa sistemi digitali. La banca dove tieni i risparmi per comprare legna da ardere traccia ogni transazione. Il supermercato del paese ha telecamere e sistemi di pagamento elettronico. Persino il postino che ti porta le bollette contribuisce a dataset logistici che alimentano algoritmi di ottimizzazione.

L'eremitaggio digitale totale nel 2025 significa essenzialmente autoescludersi dalla società civile. Puoi rinunciare a Instagram, ma non puoi rinunciare al sistema sanitario, bancario, educativo o lavorativo senza conseguenze drammatiche sulla qualità della vita.

E mentre tu costruisci la tua capanna anti-5G, i tuoi dati continuano a esistere nei database di ospedali, banche, assicurazioni, comuni, agenzia delle entrate, e vengono comunque utilizzati per addestrare sistemi che influenzeranno le generazioni future.

Il paradosso dell'eremita: il tuo isolamento protestatario non impedisce che i sistemi di IA vengano addestrati sui dati delle persone meno consapevoli, ma ti esclude dalla possibilità di influenzarne lo sviluppo in direzioni più etiche.

In sostanza, hai conquistato l'incontaminata purezza morale di chi osserva la storia dalle gradinate, mentre altri - meno illuminati ma più presenti - scrivono le regole del gioco.

Qualunque sia la tua scelta, scegli con consapevolezza, non con illusioni digitali.

Articoli citati:

Approfondimenti GDPR e legittimo interesse:

Risorse ufficiali:

Per azioni concrete: se sei in Europa, verifica le procedure ufficiali di opt-out presso il Garante Privacy. Per informazioni generali, consulta le impostazioni sulla privacy e i termini di servizio della tua piattaforma. E ricorda: nessun post sui social media ha valore legale.