Negli ultimi mesi, la comunità dell'intelligenza artificiale è stata attraversata da un acceso dibattito scaturito da due influenti paper di ricerca pubblicati da apple. Il primo, illusione-del-ragionamento-il-dibattito-che-sta-scuotendo-il-mondo-dell-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (ottobre 2024), e il secondo, "The Illusion of Thinking" (giugno 2025), hanno messo in discussione le presunte capacità di ragionamento dei Large Language Models, scatenando reazioni contrastanti in tutto il settore.

Come già analizzato nel nostro precedente approfondimento su "L'Illusione del Progresso: Simulare l'Intelligenza Artificiale Generale Senza Raggiungerla", la questione del ragionamento artificiale tocca il cuore stesso di ciò che consideriamo intelligenza nelle macchine.

I ricercatori di Apple hanno condotto un'analisi sistematica sui Large Reasoning Models (LRM) - quei modelli che generano tracce di ragionamento dettagliate prima di fornire una risposta. I risultati sono stati sorprendenti e, per molti, allarmanti.

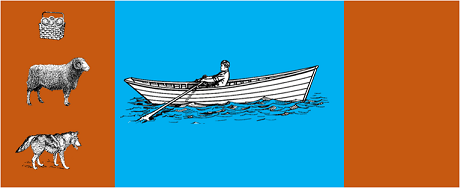

Lo studio ha sottoposto i modelli più avanzati a puzzle algoritmici classici come:

I risultati hanno mostrato che anche piccole modifiche nella formulazione dei problemi portano a variazioni significative nelle prestazioni, suggerendo una fragilità preoccupante nel ragionamento. Come riportato nella copertura di AppleInsider, "le prestazioni di tutti i modelli diminuiscono quando vengono alterati solo i valori numerici nelle domande del benchmark GSM-Symbolic".

La risposta della comunità AI non si è fatta attendere. Alex Lawsen di Open Philanthropy, in collaborazione con Claude Opus di Anthropic, ha pubblicato una replica dettagliata intitolata "The Illusion of the Illusion of Thinking", contestando metodologie e conclusioni dello studio Apple.

Quando Lawsen ha ripetuto i test con metodologie alternative - chiedendo ai modelli di generare funzioni ricorsive invece di elencare tutte le mosse - i risultati sono stati dramatically diversi. Modelli come Claude, gemini e GPT hanno risolto correttamente problemi della Torre di Hanoi con 15 dischi, ben oltre la complessità dove Apple riportava zero successi.

Gary Marcus, da sempre critico delle capacità di ragionamento degli LLM, ha abbracciato i risultati Apple come conferma delle sue tesi ventennali. Secondo Marcus, gli LLM continuano a lottare con il "distribution shift" - la capacità di generalizzare oltre i dati di training - rimanendo "buoni risolutori di problemi già risolti".

La discussione si è estesa anche alle community specializzate come LocalLlama su Reddit, dove sviluppatori e ricercatori dibattono le implicazioni pratiche per i modelli open-source e l'implementazione locale.

Questo dibattito non è puramente accademico. Ha implicazioni dirette per:

Come evidenziato in diversi approfondimenti tecnici, emerge sempre più chiaramente la necessità di approcci ibridi che combinino:

Esempio banale: un assistente AI che aiuta con la contabilità. Il modello linguistico capisce quando chiedi "quanto ho speso in trasferte questo mese?" e estrae i parametri rilevanti (categoria: trasferte, periodo: questo mese). Ma la query SQL che interroga il database, il calcolo della somma e la verifica dei vincoli fiscali? Quello lo fa codice deterministico, non il modello neurale.

Non è sfuggito agli osservatori che il paper Apple è stato pubblicato poco prima del WWDC, sollevando interrogativi sulle motivazioni strategiche. Come nota l'analisi di 9to5Mac, "il timing del paper Apple - proprio prima del WWDC - ha sollevato qualche sopracciglio. Era questa una pietra miliare della ricerca, o una mossa strategica per riposizionare Apple nel panorama AI più ampio?"

Il dibattito scaturito dai paper Apple ci ricorda che siamo ancora nelle fasi iniziali della comprensione dell'intelligenza artificiale. Come sottolineato nel nostro precedente articolo, la distinzione tra simulazione e ragionamento autentico rimane una delle sfide più complesse del nostro tempo.

La vera lezione non è se gli LLM possano o meno "ragionare" nel senso umano del termine, ma piuttosto come possiamo costruire sistemi che sfruttino i loro punti di forza mentre compensano le loro limitazioni. In un mondo dove l'AI sta già trasformando settori interi, la questione non è più se questi strumenti siano "intelligenti", ma come utilizzarli in modo efficace e responsabile.

Il futuro dell'AI enterprise probabilmente non risiederà in un singolo approccio rivoluzionario, ma nell'orchestrazione intelligente di diverse tecnologie complementari. E in questo scenario, la capacità di valutare criticamente e onestamente le capacità dei nostri strumenti diventa essa stessa un vantaggio competitivo.

Ultimi Sviluppi (Gennaio 2026)

OpenAI rilascia o3 e o4-mini: Il 16 aprile 2025, OpenAI ha rilasciato pubblicamente o3 e o4-mini, i modelli di reasoning più avanzati della serie o. Questi modelli possono ora utilizzare strumenti in modo agentivo, combinando ricerca web, analisi di file, ragionamento visivo e generazione di immagini. o3 ha stabilito nuovi record su benchmark come Codeforces, SWE-bench e MMMU, mentre o4-mini ottimizza prestazioni e costi per compiti di reasoning ad alto volume. I modelli dimostrano capacità di "pensiero con immagini", trasformando visivamente i contenuti per analisi più approfondite.

DeepSeek-R1 scuote l'industria AI: A gennaio 2025, DeepSeek ha rilasciato R1, un modello di reasoning open-source che ha raggiunto prestazioni comparabili a OpenAI o1 con un costo di training di soli $6 milioni (contro centinaia di milioni di modelli occidentali). DeepSeek-R1 dimostra che le capacità di ragionamento possono essere incentivate attraverso reinforcement learning puro, senza necessità di dimostrazioni umane annotate. Il modello è diventato l'app gratuita #1 su App Store e Google Play in decine di paesi. A gennaio 2026, DeepSeek ha pubblicato un paper espanso di 60 pagine che rivela i segreti del training e ammette candidamente che tecniche come Monte Carlo Tree Search (MCTS) non hanno funzionato per il ragionamento generale.

Anthropic aggiorna la "Costituzione" di Claude: Il 22 gennaio 2026, Anthropic ha pubblicato una nuova costituzione di 23.000 parole per Claude, passando da un approccio basato su regole a uno basato sulla comprensione dei principi etici. Il documento diventa il primo framework di una grande azienda AI a riconoscere formalmente la possibilità di coscienza o status morale dell'AI, affermando che Anthropic si preoccupa del "benessere psicologico, senso di sé e benessere" di Claude.

Il dibattito si intensifica: Uno studio di luglio 2025 ha replicato e raffinato i benchmark Apple, confermando che gli LRM mostrano ancora limitazioni cognitive quando la complessità aumenta moderatamente (circa 8 dischi nella Torre di Hanoi). I ricercatori hanno dimostrato che questo non dipende solo da vincoli di output, ma anche da limiti cognitivi reali, evidenziando che il dibattito è tutt'altro che concluso.

Per approfondimenti sulla strategia AI della vostra organizzazione e sull'implementazione di soluzioni robuste, il nostro team di esperti è a disposizione per consulenze personalizzate.